Tavaly elkövettem egy hosszabb poszt megírását a keresőoptimalizálás talán legkritikusabb lépéséről, a kulcsszó választásról diverzifikált kulcsszó kosár címmel. Azóta sok idő eltelt és némi tapasztalattal sikerült gazdagodnom.

Az iWebTool fórum egyik kiváló tagja hívta fel a figyelmemet erre a nagyon hasznos videóra hónapokkal ezelőtt, amely a Google Trendsben rejlő lehetőséget hivatott demonstrálni.

A videó sajnos csak angol nyelven létezik, de a mondandóját az alábbiakban megkísérlem magyar környezetbe átültetni.

Első lépésként szükség lesz egy szóra, amelyre elsőként szereplünk a Google találati oldalain és a Google Trends eszköz is összegyűjtött megfelelő mennyiségű információt annak keresési trendjével kapcsolatban. Szerencsére ilyennel pont rendelkezem, így következhet a demonstráció.

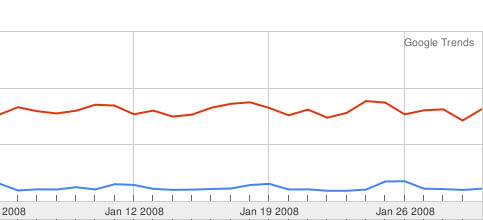

Az ábrán két Magyarországra szűkített lekérdezés összehasonlítása látható. Sajnos nem a piros sáv az én kulcsszavam, de a piros az egyik kedvencem, a sex. A két sáv egymáshoz mért arányát és ezáltal a keresési trendek nagyságát talán könnyebben összemérhetjük a vízszintes diagram segítségével.

A kék sáv hossza heti szinten 150 darab átkattintást jelent a Google oldalairól, abban az esetben, ha sikerült az élen leparkolni. Kalkulációm szerint a sex szó hasonló pozicíó esetén heti 1000 darab kattintást jelenthet.

Mindenkit szeretnék megkérni, hogy tessék ezt a feltételezést nyugodtan megerősíteni, vagy cáfolni.

Mi van akkor, ha az oldalunk témája nem igazán tartozik a “nagyobb” tortaszeletek közé?

Ebben az esetben legjobb javaslatom a Google Suggest. Egy évvel ezelőtt még az AdWords kulcsszó választó alkalmazást ajánlottam volna, de manapság egyáltalán nem tartom egy nyerő ötletnek annak eredményeire bármit is alapozni.

Tehát irány a Google Suggest input formja és ostromra fel! Érdemes minden lehetséges releváns kifejezést végigtesztelni, hiszen számottevő keresési trend esetén autofill jelenséggel fogunk találkozni, azaz felkínálja a kifejezést még annak teljes beírását megelőzően.

Akkor most kicsit ugorjunk előre az időbe és feltételezzük, hogy az oldalunkkal kapcsolatban számos információ elérhető a Google Webmaster Tools által. A célunk természetesen a kulcsszavain diverzifikálása, azaz szélesíteni azon kifejezések halmazát, amellyel RELEVÁNS látogatókat hozhatunk az oldalunkra.

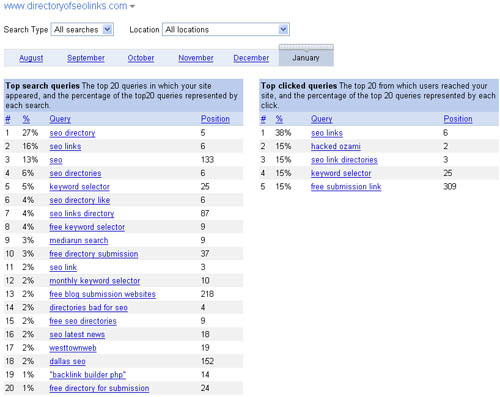

Következzék tehát a GWT számomra legkedvesebb szolgáltatása a Top search queries. Sajnos nem tudom, hogyan került ennek lefordításra, de az alábbi kép alapján azonnal világossá fog válni mindenki számára, hogy miről beszélek.

A jobb oldali oszlopban láthatóak azok a kifejezések, amelyre kattintva számottevő mennyiségű látogatóra tettünk szert. Érdemes pár percet eltölteni és elmélázni azon, vajon merre kellene az oldalunk célkeresztjét irányítani. Szerinted melyik lenne a legértékesebb kifejezés?

Ez pusztán egy költői kérdés volt, ha nem jut eszedbe mire gondoltam, kérlek bátran kérdezz.

További kellemes napot!